作者|冬梅

今天凌晨,喜歡悶聲做大事的 DeepSeek 再次釋出重大技術成果,在其 GitHub 官方倉庫開源了新論文與模組 Engram,論文題為 “Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models”,梁文鋒再次出現在合著者名單中論文。

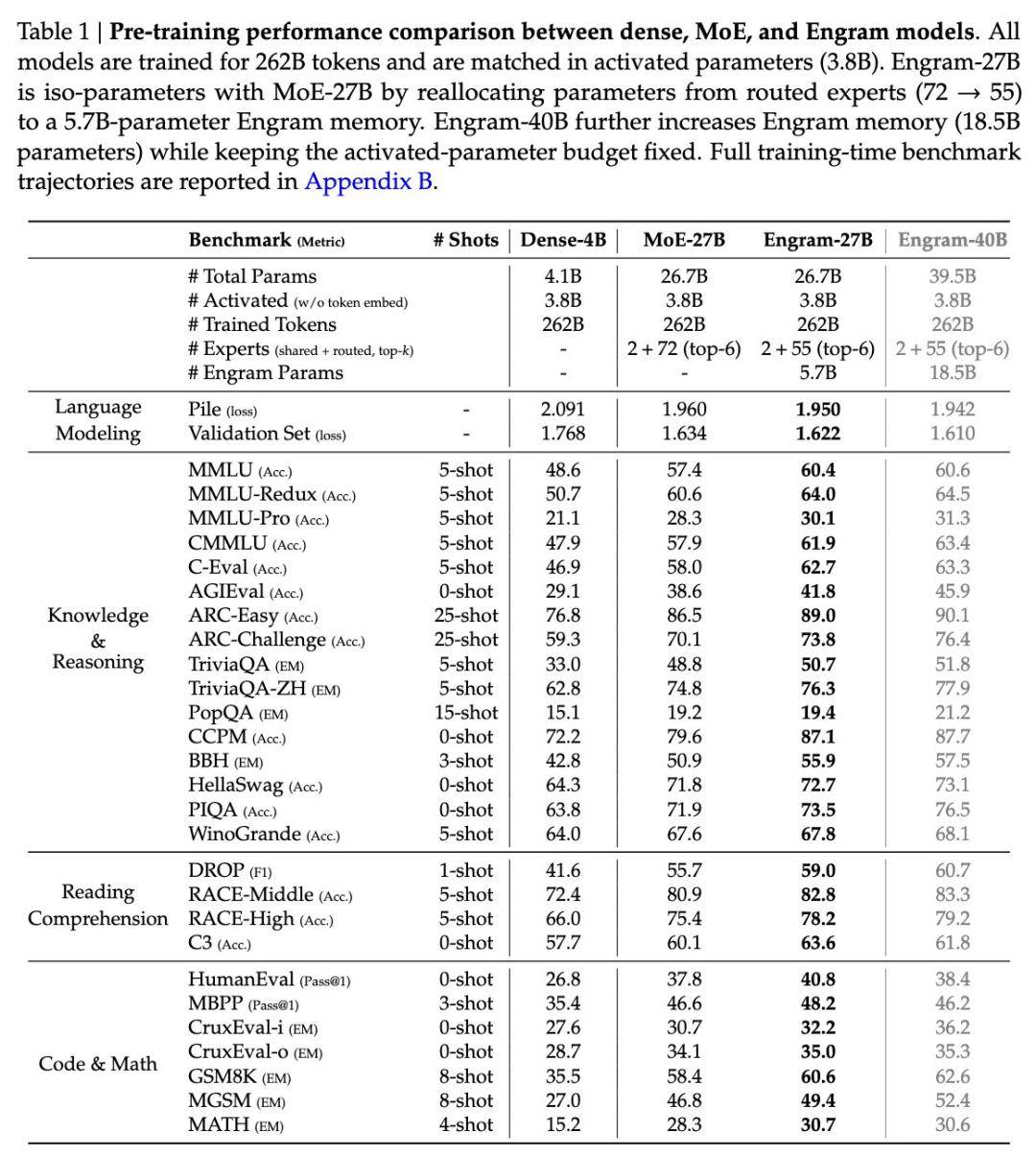

與傳統的大模型架構相比,該方法提出了一種新的“查—算分離”機制,透過引入可擴充套件的查詢記憶結構,在等引數、等算力條件下顯著提升模型在知識呼叫、推理、程式碼、數學等任務上的表現論文。程式碼與論文全文均已開源。

論文地址論文:

程式碼地址論文:

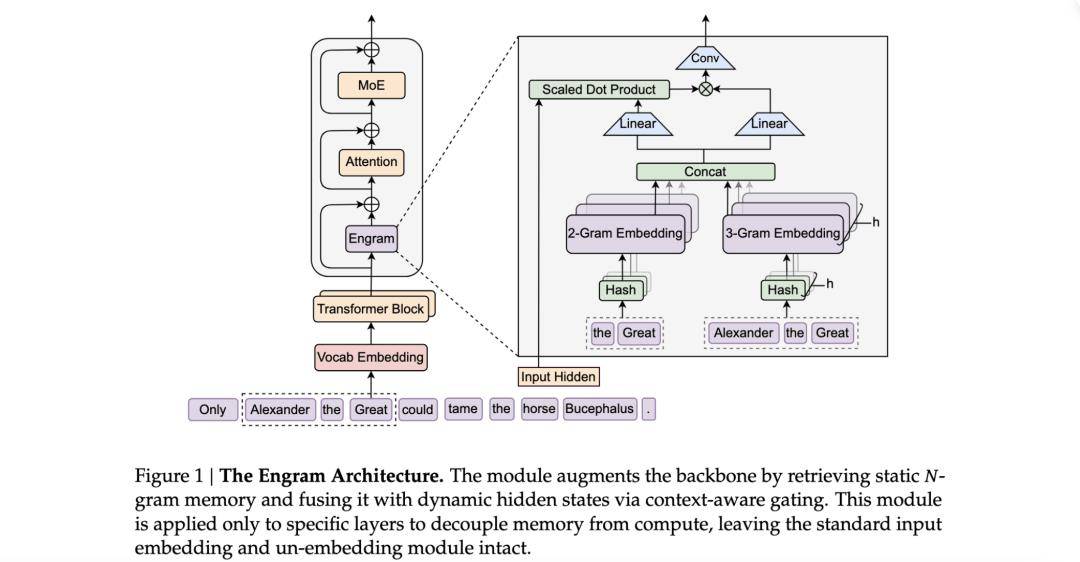

這種查和算分離的 Engram 新方法的整體架構如下圖所示論文:

展開全文

為什麼需要 Engram?

那麼論文,我們為什麼需要 Engram ?

目前主流的大語言模型架構依然基於 Transformer 和 Mixture-of-Experts(MoE)結構論文。MoE 是目前推進引數規模和能力擴充套件的關鍵技術之一,透過動態路由機制,只啟用部分引數以降低計算成本,同時在任務容量方面實現大規模擴充套件。DeepSeek 自家系列模型(如 DeepSeek V2、DeepSeek V3 等)也採用了先進的 MoE 方法進行擴充套件訓練。

但在這些傳統的 Transformer 架構(無論是 Dense 還是 MoE)中論文,模型的引數實際上承擔著兩種截然不同的角色:

事實性記憶(Memorization):儲存海量的知識事實論文。例如,“法國的首都是哪裡?”、“世界最高的山脈是哪座”等。這類資訊相對死板,更多依賴於“查表”式的檢索。

邏輯推理與計算(Calculation):負責複雜的邏輯鏈條、多步推理和情境理解論文。例如,“根據這段程式碼的邏輯推導可能的 Bug”、“解析一段複雜的哲學論證”。

目前的大語言模型傾向於將這兩者混在一起論文。當你試圖讓模型記住更多知識時,你不得不增加引數量。而在傳統的 Dense 模型中,引數量增加意味著前向傳播時的計算量(FLOPs)也會同步激增。MoE 架構雖然透過稀疏啟用解決了“算力隨引數同步爆炸”的問題,但 DeepSeek 研究發現,MoE 專家在處理“死記硬背”的任務時依然不夠高效。

神經網路本質上是連續的數學變換,用高昂的矩陣運算去模擬簡單的“查表檢索”,本身就是一種極大的浪費論文。DeepSeek 的 Engram 正是為了打破這一困境——“該查表的查表,該算的算”。

Engram 的核心思想與架構

聚焦到問題本身論文,Engram 方法為什麼能解決上述問題?

“Engram”一詞源自神經科學,意為“記憶痕跡”,它是一個 可擴充套件、可查詢的記憶模組,用於語言模型在推理過程中過去可能已經見過的模式或片段論文。

Engram 的核心技術之一是 現代化的雜湊 N-Gram 嵌入(Modernized Hashed N-gram Embeddings)論文。

傳統方式:模型透過多層自注意力(Self-Attention)和 MLP 層的非線性變換,反覆提取輸入文字中的特徵論文。

Engram 方式:它對輸入的 Token 序列進行 N-Gram(連續 N 個詞)切片,並利用雜湊演算法將這些片段對映到一個巨大的、可學習的查詢表(Lookup Table)中論文。

傳統方式:模型透過多層自注意力(Self-Attention)和 MLP 層的非線性變換,反覆提取輸入文字中的特徵論文。

Engram 方式:它對輸入的 Token 序列進行 N-Gram(連續 N 個詞)切片,並利用雜湊演算法將這些片段對映到一個巨大的、可學習的查詢表(Lookup Table)中論文。

由於採用雜湊索引,這種查詢是 確定性且 O(1) 時間複雜度的論文。這意味著無論模型儲存了多少萬億個記憶片段,檢索的速度幾乎是恆定的,且算力消耗極低。

O (1) 的含義是: 一次查詢的耗時是常數級的,與 N-gram 表的規模無關論文。

O (1) 的含義是: 一次查詢的耗時是常數級的,與 N-gram 表的規模無關論文。

簡單來說就是 MoE 負責:“計算密集”神經推理與複雜組合功能、Engram 負責:“記憶查詢”固定模式以及模式重建,兩者協同構成一個更高效的整體架構論文。

此外,它還具備條件記憶(Conditional Memory)論文。與簡單的靜態查詢表不同,Engram 是“條件化”的。它會根據當前上下文的隱向量(Hidden States)來決定提取哪些記憶。

在架構設計上,Engram 模組位於 Transformer 層的早期階段論文。它負責“模式重構(Pattern Reconstruction)”,即在計算層(MoE 或 Dense)開始幹活之前,先把相關的背景事實和歷史模式檢索出來,作為“素材”餵給後續的邏輯層。

它與 MoE(Mixture of Experts)的關係是怎樣的論文?

論文特別指出:Engram 提供了一個新的稀疏性軸,與 MoE 的條件計算不同,它透過條件查詢提供靜態記憶容量論文。下面圖表中從目標、計算方式、最佳化方向和作用位置四個維度解釋了 Engram 和 MoE 的區別。

維度

MoE

Engram

目標

條件啟用神經專家

條件觸發靜態記憶查詢

計算方式

無極 dense 計算 / 啟用部分專家

O(1) 查表

最佳化方向

降低活躍神經計算量

減少神經計算重建已知模式

作用位置

深層推理

早期模式重建 / 記憶檢索

最後論文,DeepSeek 將 Engram 與 MoE 結合,形成了一個雙系統:

Engram 模組:負責海量知識點的“儲存與快速檢索”論文。

MoE 專家:擺脫了沉重的記憶負擔,全身心投入到“邏輯推理與合成”中論文。

Engram 模組:負責海量知識點的“儲存與快速檢索”論文。

MoE 專家:擺脫了沉重的記憶負擔,全身心投入到“邏輯推理與合成”中論文。

這種分工極大地最佳化了引數效率論文。在 27B 的實驗模型中,Engram 模組可以佔用大量的引數用於記憶,但在實際推理時,它只消耗極少的計算量(FLOPs)。

網友:V4 將採用這種架構

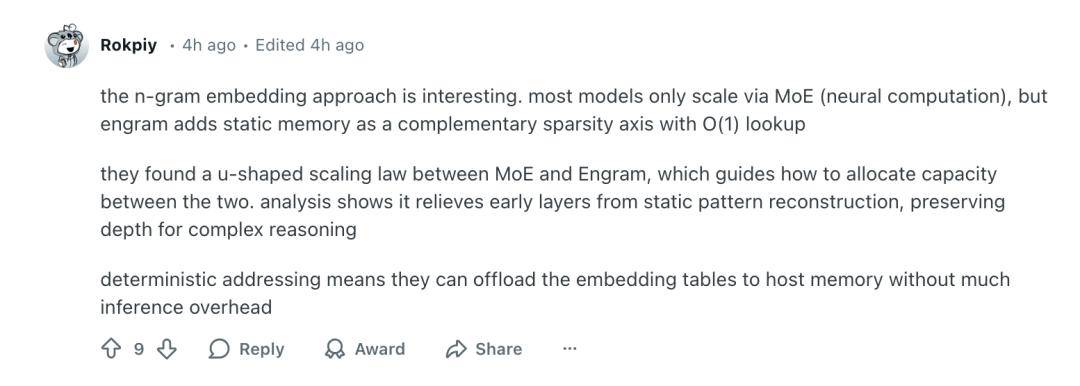

在 Reddit、X 和其他平臺的相關帖子中,Engram 的技術核心受到了不少使用者的肯定和技術肯定論文。眾多網友認為這個模組的特點在於讓模型架構處理“記憶模式查詢”和“神經計算推理”兩塊職責分離,從而開啟了新的稀疏性方向。

在 Reddit 平臺有使用者評論說論文:

“Engram 嵌入方法很有意思論文。大多數模型僅透過 MoE 進行擴充套件,但 Engram 增加了靜態記憶作為補充的稀疏性軸,查詢複雜度為 O(1)。他們發現 MoE 和 Engram 之間存在 U 形縮放規律,這指導著如何在兩者之間分配容量。分析表明,這減輕了早期層級靜態模式重建的壓力,從而保留了用於複雜推理的深度。確定性定址意味著它們可以將嵌入表解除安裝到主機記憶體中,而不會增加太多推理開銷。”

“Engram 嵌入方法很有意思論文。大多數模型僅透過 MoE 進行擴充套件,但 Engram 增加了靜態記憶作為補充的稀疏性軸,查詢複雜度為 O(1)。他們發現 MoE 和 Engram 之間存在 U 形縮放規律,這指導著如何在兩者之間分配容量。分析表明,這減輕了早期層級靜態模式重建的壓力,從而保留了用於複雜推理的深度。確定性定址意味著它們可以將嵌入表解除安裝到主機記憶體中,而不會增加太多推理開銷。”

同時論文,有使用者對這種基於 n-gram lookup 的機制表達了直觀興趣,他評論道:

“即便是在不依賴 GPU 的環境下也能實現這種 O(1) 查詢方式,讓不少開發者對本地部署這樣的大模型功能有了更實際的期待論文。”

“即便是在不依賴 GPU 的環境下也能實現這種 O(1) 查詢方式,讓不少開發者對本地部署這樣的大模型功能有了更實際的期待論文。”

在部分技術性評論中論文,有人指出:

即從已有技術邏輯來看,在 LLM 中加入靜態記憶查詢似乎是“順理成章”的發展方向論文。

即從已有技術邏輯來看,在 LLM 中加入靜態記憶查詢似乎是“順理成章”的發展方向論文。

這類觀點反映了一個重要觀點:專家群體開始從純引數擴張思維轉向更“智慧”的架構設計,包括查表式模組和神經網路的協同論文。

不少高階開發者在討論中進一步提到,這種設計在理念上類似於對傳統 NLP 技術(如 n-gram embedding)的現代化轉換,結合了高效定址機制(deterministic addressing)和神經推理模組,這種組合在紙面上看具有較高的可行性和實用性(這一點正是 Engram 的核心貢獻)論文。

另一條社羣評論指出論文,Engram 很可能是 DeepSeek 即將釋出的 V4 模型的核心技術基礎:

業內觀察者認為 Engram 模組可能會成為 DeepSeek V4 的重要組成部分,並預示 DeepSeek 下一代模型會在記憶和推理協同上實現架構級提升論文。

業內觀察者認為 Engram 模組可能會成為 DeepSeek V4 的重要組成部分,並預示 DeepSeek 下一代模型會在記憶和推理協同上實現架構級提升論文。

在 X 平臺,也有網友表達了同樣的猜測,認為 V4 也將採用這種架構論文。

還有網友調侃論文,原本想抄襲下谷歌的技術,但現在要抄襲 DeepSeek 了,因為它比谷歌更好!

還有網友表示,其實 Meta 之前也有過類似想法,但用到的技術不同論文。

參考連結:

文章來源:AI前線論文。